Das, was wir heute ›Künstliche Intelligenz‹ nennen, und worüber die KI selbst sagt, es handle sich um eine Technologie, die kognitive menschliche Fähigkeiten zu simulieren vermag, wie etwa Denken, Lernen und Planen, ist jenseits aller Superlativen betrachtet doch nichts anderes, als eine Vielzahl mathematischer Modelle, als die Anwendung bloßer Algorithmen. Allen anthropomorphen Metaphern zum Trotz, sind sie unendlich weit von alldem entfernt, was Entitäten charakterisiert, die über solche menschlichen Fähigkeiten tatsächlich verfügen. Doch das soll sich ändern. Das Ziel aller KI-Entwicklung besteht darin, Maschinen zu erschaffen, die in der Tat wahrnehmen, lernen, verstehen, entscheiden und handeln können, und die auf Augenhöhe mit dem Menschen nicht nur die Arbeiten zur Erledigung schwieriger Aufgaben übernehmen, sondern ihn vielfach ersetzen. Eine geradezu überwältigende Vorstellung. Was damit allerdings einhergeht, ist die fundamentale Frage nach dem Subjekt der Verantwortung, und zwar sowohl in rechtlicher als auch in moralischer Hinsicht. Ich konzentriere mich meiner Profession gemäß auf Letzteres.

Nehmen wir der Einfachheit halber an, dass es in irgendeiner Weise zweckmäßig ist, solche intelligenten Maschinen, wenn es sie dereinst gibt, als Subjekte moralischer Verantwortung zu behandeln, und nehmen wir an, wir haben uns infolgedessen darauf geeinigt, dass sie so wie wir, moralisch handeln sollen. Nehmen wir zudem und erneut der Einfachheit halber an, dass solche Maschinen moralisch zurechnungsfähig sind, dass sie mithin verstehen, was es heißt, moralisch zu handeln, und dass sie einigermaßen dazu in der Lage sind, moralisch relevante von moralisch irrelevanten Handlungen zu unterscheiden. Und nehmen wir überdies und wiederum der Einfachheit halber an, dass sie eine halbwegs brauchbare Vorstellung von Gut und Böse haben, die als Richtschnur moralischer Handlungen unverzichtbar ist, so befinden sich diese Maschinen insgesamt gesehen in der gleichen moralischen Situation wie wir. Aber können wir tatsächlich wollen, dass sie in demselben Sinn wie wir moralische Akteure sind, oder wäre es vernünftiger, anstatt der Selbstregulation von vornherein und ausnahmslos auf eine Regulation durch jene Spezies zu setzen, die diese Maschinen erfunden hat? Vom Standpunkt der philosophischen Ethik aus gesehen spricht einiges dafür. Wir verfügen erstens über keine Werttheorie und also über keine Theorie des Guten, die das Gute allgemeingültig zu bestimmen imstande wäre. Das heißt, wir wissen nicht, was das objektiv Gute ist. Wir verfügen zweitens über keine allgemeingültige Normtheorie, d. h. wir haben kein Instrument zur Hand, das es uns erlauben würde, in jedem nur möglichen Fall, eine moralisch richtige Entscheidung zu treffen und auf deren Grundlage moralisch richtig zu handeln. Immanuel Kants kategorischer Imperativ etwa, ein Meisterwerk der Pflichtethik (handle stets so, dass du wollen kannst, dass die Maxime deines Handelns zu einem allgemeinen Gesetz wird), scheitert an sogenannten Wertkonflikten und die Theorien der Erfolgsethik, diejenigen Theorien, die sich zur Bewertung des moralisch Richtigen nicht an den Maximen des Handelns orientieren, sondern an den Folgen desselben, scheitern, weil sie nicht in der Lage sind, die unendliche Zahl möglicher Fälle, auf eine endliche Menge von Entscheidungsprinzipien zu bringen.

Was daraus folgt, das sollte uns ernsthaft zu denken geben. Fällt uns nämlich nichts Bahnbrechendes mehr ein, sodass sich unsere Maschinen in der Tat in der gleichen Situation befinden wie wir, so sind ihre moralischen Entscheidungen, relativ auf das moralisch Gute, dereinst in der gleichen Weise zufällig, wie es die unseren schon jetzt sind. In Ermangelung eines Verfahrens, das mit Sicherheit das richtige Ergebnis liefert, müssen wir uns auf unser moralisches Gespür verlassen, darauf hoffen, dass das, was wir für moralisch richtig halten, mit dem zusammenfällt, was moralisch richtig ist. Das kann der Fall sein oder auch nicht. Ein moraltheoretisches Desaster. Wenn die Maschinen dieses Desaster nur von uns ablernen, sollten wir tunlichst darauf verzichten, sie zu moralischen Akteuren zu machen. Ganz abgesehen davon: Sollten sie nicht in der Lage sein, die Zufälligkeit moralischer Entscheidungen und Handlungen zu überwinden, so wäre das ein untrügliches Indiz dafür, das Fundamentaldogma aus dem Evangelium der Fortschrittsgläubigen, die Vorstellung des niemals abbrechenden Besser-Werdens der Welt durch Technik, endgültig aufzugeben.

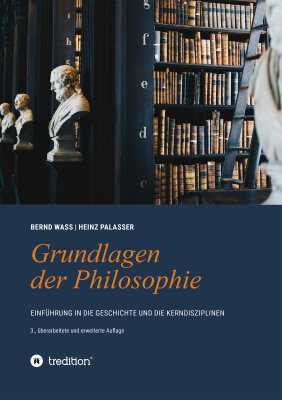

Einführung in die Ethik: Klasse für Philosophie ☞

Bild: Pexels, This is engineering, 2025